Digitale Resilienz: Infrastruktur als Schutzfaktor

Das fundamentale Umdenken in der globalen Sicherheitsarchitektur

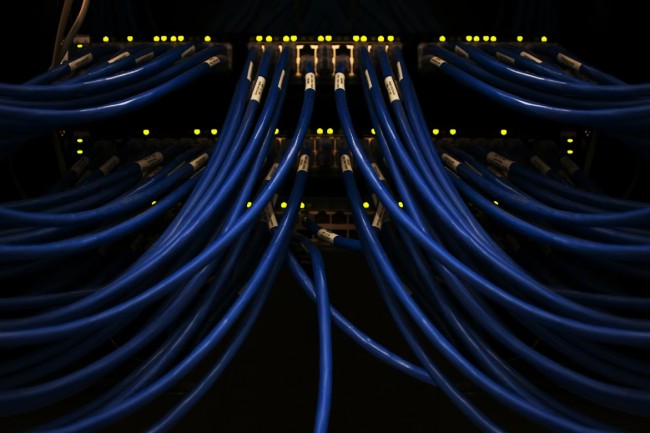

In einer Ära, die von geopolitischen Spannungen und einer exponentiell wachsenden Abhängigkeit von virtuellen Dienstleistungen geprägt ist, hat sich der Begriff der Sicherheit grundlegend gewandelt. Es geht längst nicht mehr nur um Firewalls oder Virenschutzprogramme auf Endgeräten, sondern um die physische und systemische Härtung der Netzwerke selbst, die unsere moderne Gesellschaft tragen. Die jüngsten Investitionsankündigungen großer Technologiekonzerne, wie etwa die Zusage von Google, in den kommenden Jahren rund 5,5 Milliarden Euro in deutsche Rechenzentren und Cloud-Infrastrukturen zu investieren, sind weit mehr als bloße Wirtschaftsnachrichten. Sie symbolisieren eine Verschiebung hin zur digitalen Resilienz als Standortfaktor.

Wenn Infrastruktur als Schutzfaktor begriffen wird, bedeutet dies, dass die physische Basis des Internets so redundant und leistungsfähig gestaltet sein muss, dass sie externen Schocks standhält. Diese Schocks können vielfältiger Natur sein, von gezielten Cyberangriffen auf staatliche Institutionen über Energieengpässe bis hin zu physischen Beschädigungen durch Naturkatastrophen. Die Bundesregierung und lokale Behörden erkennen zunehmend, dass digitale Souveränität ohne eigene, auf europäischem Boden verankerte Kapazitäten eine Illusion bleibt.

Die technische Notwendigkeit von Hochverfügbarkeit und Latenzminimierung

In der modernen Softwareentwicklung und Videospielbranche ist die Symbiose aus Rechenleistung und minimaler Latenz zum entscheidenden Innovationsmotor geworden. Da lokale Hardware oft an physikalische Grenzen stößt, verlagern Entwickler rechenintensive Prozesse zunehmend in die Cloud, um immersive Erlebnisse ohne Performance-Einbußen zu ermöglichen. Dieser Trend wird besonders deutlich, wenn man betrachtet, wie plattformübergreifendes Gaming und Cloud-Streaming-Dienste eine Infrastruktur verlangen, die selbst bei Millionen gleichzeitiger Zugriffe stabil bleibt. Damit wird auch deutlich, warum Diskussionen über keine Datenkontrolle im iGaming nicht als Risiko, sondern als bewusste technische Designentscheidung verstanden werden können, wenn transparente Serverlogiken, klar definierte Zuständigkeiten und nachvollziehbare Prozesse die Integrität des Systems absichern.

Die Erwartungshaltung der Nutzer richtet sich längst nicht mehr nur auf visuelle Qualität oder Framerates, sondern auf eine jederzeit verfügbare, unterbrechungsfreie Interaktion, unabhängig davon, ob komplexe Physikberechnungen, Matchmaking-Algorithmen oder Live-Services im Hintergrund arbeiten. Dass selbst Technologiekonzerne mit eigener Chipentwicklung auf externe Rechenzentren zurückgreifen, verdeutlicht die physikalischen Grenzen mobiler Hardware und zeigt, wie stark Software-Innovation heute von skalierbarer Infrastruktur abhängt. Für Online-Games mit Millionen paralleler Sessions bedeutet dies, dass Latenzminimierung, dynamische Lastverteilung und automatische Failover-Mechanismen zur Grundvoraussetzung werden, um Spielabbrüche oder inkonsistente Zustände zu vermeiden. Sobald Server nicht flexibel reagieren, leidet die Immersion unmittelbar, was sich in kompetitiven Umgebungen direkt auf Fairness und Vertrauen auswirkt.

Kreative Lösungen auf kommunaler Ebene als Basis der Stabilität

Abseits der großen geopolitischen Strategien zeigt sich die wahre Bewährungsprobe der digitalen Resilienz oft auf der lokalen Ebene, in den Städten und Gemeinden. In der Metropolregion Nürnberg, Fürth und Erlangen lässt sich beobachten, wie Kommunen trotz angespannter Haushaltslage in die digitale Daseinsvorsorge investieren. Hier wird Infrastruktur nicht nur als technisches, sondern als soziales Projekt verstanden.

Die Herausforderung für die Kommunen besteht darin, diese komplexen Systeme zu warten und gleichzeitig den Datenschutz zu gewährleisten. Ohne qualifizierte IT-Experten, die diese kommunalen Netzwerke gegen Angriffe härten und warten können, werden digitalisierte Verwaltungen schnell zum Sicherheitsrisiko. Die Abhängigkeit von Fördermitteln des Bundes oder der EU, um diese Projekte überhaupt erst anzustoßen, zeigt zudem die finanzielle Fragilität der kommunalen Digitalisierung. Eine echte Resilienz erfordert jedoch dauerhafte Budgets für Wartung und Sicherheit, nicht nur für den initialen Rollout neuer Prestige-Projekte.

Quantencomputing und die nächste Generation

Abschließend muss der Blick auf die Technologien gerichtet werden, die heute noch in den Kinderschuhen stecken, aber die Anforderungen an unsere Infrastruktur in den nächsten zehn Jahren diktieren werden. Extended Reality (XR) und Quantencomputing werden Datenmengen und Verarbeitungsgeschwindigkeiten erfordern, die mit heutigen Netzen kaum zu bewältigen sind. Die aktuelle Infrastruktur ist für diese „Frontier Technologies“ noch nicht ausgelegt. Wenn wir heute Kabel verlegen und Server bauen, müssen diese bereits „Quantum-ready“ sein, insbesondere im Hinblick auf Verschlüsselungsstandards. Die Zusammenarbeit zwischen Sektoren, wie sie das „Connected Future Initiative“ des Weltwirtschaftsforums fordert, ist essenziell, um nicht in eine technologische Sackgasse zu laufen.

Apple, Google und andere Tech-Giganten bereiten sich durch ihre massiven Investitionen auf genau diese Zukunft vor, in der KI-Agenten autonom handeln und immersive Welten nahtlos in den Alltag integriert werden. Für den Wirtschaftsstandort Deutschland und Europa bedeutet dies, dass das Zögern bei der Infrastrukturmodernisierung keine Option ist. Wer jetzt spart, zahlt später doppelt. Durch den Verlust an Wettbewerbsfähigkeit und durch die Anfälligkeit gegenüber Cyber-Bedrohungen. Digitale Resilienz ist kein Zustand, der einmal erreicht und dann abgehakt wird; sie ist ein kontinuierlicher Prozess der Anpassung, Härtung und Erneuerung. Nur wenn Staat, Wirtschaft und Gesellschaft die digitale Infrastruktur als das zentrale Nervensystem unseres Zusammenlebens begreifen und entsprechend schützen, können wir die Vorteile der digitalen Dekade sicher und souverän nutzen.